Wenn es um die Sichtbarkeit einer Website in Suchmaschinen geht, denken viele zuerst an Keywords, Backlinks oder Content-Strategien. Dabei wird oft übersehen, wie wichtig die richtige Steuerung von Suchmaschinen-Crawlern ist. Genau hier kommt die robots.txt ins Spiel: eine kleine Textdatei mit großer Wirkung.

Sie entscheidet darüber, welche Bereiche deiner Website von Google und Co. erfasst werden und welche nicht – und kann damit direkten Einfluss auf deinen WordPress Pagespeed, deine Rankings und die Effizienz des Crawlings nehmen. In diesem Artikel zeige ich, warum die robots.txt so wichtig ist, wie sie aufgebaut ist und worauf du achten solltest, um das volle Potenzial deiner Website auszuschöpfen.

Was ist die robots.txt?

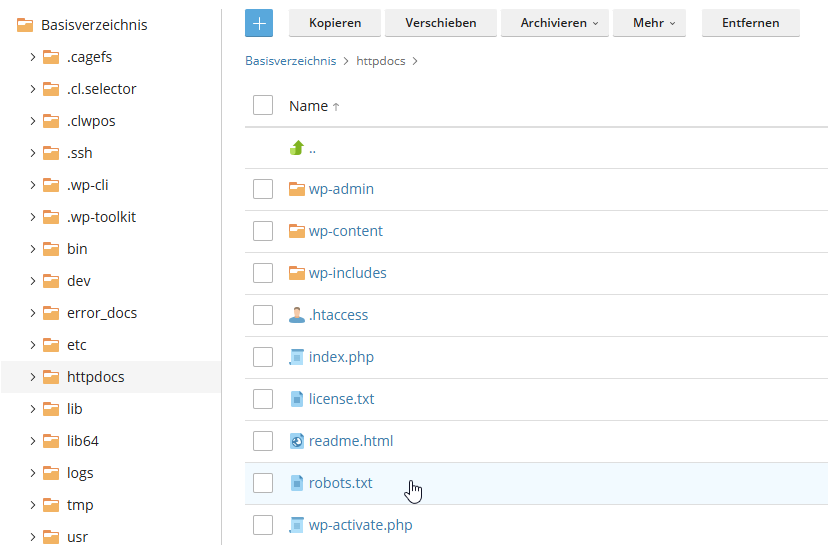

Die robots.txt ist eine kleine Textdatei, die auf deiner Website liegt (normalerweise im Ordner httpsdocs im Hauptverzeichnis deiner WordPress Installation). Auf das Hauptverzeichnis kannst du entweder direkt über dein WordPress Hosting oder per FTP zugreifen. Die robots.txt dient dazu, Crawlern von Suchmaschinen (wie dem Googlebot), von sozialen Medien (wie TikTok oder Facebook) oder KI (wie Chat GPT Crawlern) Anweisungen zu geben, welche Seiten oder Bereiche deiner Website sie indexieren dürfen oder nicht.

Wo kommt die robots.txt zum Einsatz?

Die robots.txt kommt überall dort zum Einsatz, wo Suchmaschinen oder andere Crawler gesteuert werden sollen, also immer auf Websites. Genauer gesagt:

- Auf der eigenen Website

Sie liegt im Hauptverzeichnis der Website, z. B.:

https://www.deine-website.de/robots.txt

Sobald ein Crawler deine Seite besucht, schaut er zuerst hier nach, ob es spezielle Regeln gibt.

- Typische Einsatzbereiche

- WordPress-Websites:

Bereiche wie /wp-admin/, /wp-includes/ oder Plugin-Ordner können gesperrt werden, damit sie nicht in Suchmaschinen auftauchen. - E-Commerce-Shops:

Warenkorbseiten, interne Filterseiten oder Testseiten werden oft ausgeschlossen. - Unternehmenswebsites:

Admin-Bereiche oder private Unterseiten, die nicht für die Öffentlichkeit bestimmt sind. - Entwicklungs- oder Testserver:

Sites, die noch im Aufbau sind, können komplett blockiert werden (Disallow: /).

- WordPress-Websites:

Wie ist die robots.txt aufgebaut?

Die robots.txt funktioniert nach einem klaren, standardisierten Aufbau: Sie besteht aus Anweisungen, die den Suchmaschinen-Crawlern mitteilen, welche Bereiche einer Website sie durchsuchen dürfen und welche nicht.

Grundsätzlich besteht eine robots.txt aus Blöcken, die jeweils für einen oder mehrere Crawler gelten. Jeder Block beginnt mit der Zeile User-agent, gefolgt vom Namen des Crawlers, auf den die Regeln zutreffen.

Das Sternchen * wird verwendet, um alle Crawler gleichzeitig anzusprechen. Danach folgen die eigentlichen Anweisungen, meist in Form von Disallow oder Allow. Mit Disallow wird ein Pfad angegeben, den der Crawler nicht durchsuchen soll, während Allow Pfade explizit freigibt, selbst wenn der übergeordnete Ordner gesperrt ist.

Das ist die Standard robots.txt. in WordPress:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpLegende:

User-agent → für welchen Crawler die Regel gilt (* bedeutet alle Crawler)

Disallow → Pfade, die nicht gecrawlt werden sollen

Allow → Pfade, die explizit erlaubt sind (nützlich, wenn ein Unterordner innerhalb eines gesperrten Bereichs erlaubt sein soll)

Bei jeder WordPress-Installation wird automatisch eine Standard-robots.txt-Datei erstellt. Darin sorgt der Eintrag Disallow: /wp-admin dafür, dass dein sensibles Admin-Dashboard vor Suchmaschinen-Crawlern geschützt bleibt. Du musst also keine eigene Datei anlegen, sondern kannst die automatisch und dynamisch generierte Variante nutzen.

Wichtiger Hinweis für WordPress Nutzer: Diese Datei wird dynamisch erstellt und liegt nicht als feste Datei auf deinem Server. Das heißt, die Standard-Datei kannst du nicht einfach per FTP oder über deine WordPress Hosting Oberfläche aufrufen und bearbeiten.

Wichtig zu wissen:

- Keine Sicherheitsmaßnahme:

robots.txt verhindert nur das Crawlen, nicht den Zugriff auf die Seiten. Wer die URL kennt, kann trotzdem darauf zugreifen. - Suchmaschinen können Regeln ignorieren:

Manche Crawler halten sich nicht an die Regeln. - Nicht für komplette Indexierungskontrolle:

Um Inhalte vollständig aus Suchmaschinen zu entfernen, sollte man zusätzlich noindex-Meta-Tags verwenden.

Beispiele einer robots.txt

Du hast nun bereits die Standard-Version kennengelernt. Mit der robots.txt hast du viele Möglichkeiten, daher möchte ich dir fünf Beispiele zeigen, mit denen du deine robots.txt für SEO, Sicherheit und Performance optimieren kannst.

Beispiel 1: Admin-Bereich schützen

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.phpDas entspricht tatsächlich auch der Standard robots.txt von WordPress. Mit den Codezeilen schützt die robots.txt den WordPress-Adminbereich deiner Website vor Crawlern. So werden sensible Dateien aus dem Backend nicht indexiert. Die Ausnahme admin-ajax.php erlaubt Crawlern, diesen wichtigen Endpunkt zu erreichen, z. B. für bestimmte Plugin- oder Sitemap-Aufrufe, während der Rest des Admin-Bereichs geschützt bleibt.

Beispiel 2: Verzeichnisse für Medien blockieren

User-agent: *

Disallow: /wp-content/uploads/private/In diesem Beispiel wird das Upload-Verzeichnis “private”, in dem vertrauliche Bilder oder Daten gesichert sind, für alle Crawler und Suchmaschinen gesperrt. Alle anderen hochgeladenen Dateien werden weiterhin wie gewohnt gecrawlt.

Beispiel 3: Entwicklungs- oder Staging-Bereiche ausschließen

# Block 1: Googlebot

User-agent: Googlebot

Disallow: /staging/

Disallow: /dev/

# Block 2: Alle anderen Bots

User-agent: *

Allow: /💡Hinweis: Der “#" dient ausschließlich als Kommentarzeichen. Alles, was nach einem # steht, wird von Suchmaschinen ignoriert und nicht ausgeführt. So lassen sich Dateien wie die robots.txt oder .htaccess übersichtlicher gestalten.

Dieses Beispiel zeigt eine robots.txt-Datei mit zwei Blöcken. Der erste Block verbietet dem Googlebot das Crawlen von Entwicklungs- oder Staging-Bereichen. Der zweite Block erlaubt allen anderen Bots das Crawlen der Website.

Beispiel 4: Kategorien und Schlagwörter ausblenden

User-agent: *

Disallow: /category/

Disallow: /tag/Mit diesem Beispiel verbietest du den Suchmaschinen das Crawlen von Kategorie- und Schlagwort-Archiven, die automatisch von WordPress angelegt werden und oft nicht aktiv genutzt werden. Diese Seiten erzeugen häufig Duplicate Content, weil die gleichen Beiträge sowohl über die Startseite, Kategorien, Tags als auch über die eigentliche Beitrags-URL erreichbar sind.

Beispiel 5: Bestimmte Dateitypen blockieren

User-agent: *

Disallow: /*.pdf$

Disallow: /*.zip$

Dieses Beispiel blockiert PDF- und ZIP-Dateien vor dem Crawlen. Das kann sinnvoll sein, wenn du Download-Materialien oder interne Dokumente anbietest, die nicht in den Suchergebnissen auftauchen sollen.

Wie rufe ich die robots.txt Datei auf?

Die robots.txt lässt sich ganz einfach aufrufen, weil sie standardmäßig im Hauptverzeichnis deiner Website liegt. Du musst lediglich die URL deiner Domain eingeben und am Ende /robots.txt anhängen.

Beispiel: https://deine-website.de/robots.txt

Wenn die Datei existiert, wird sie im Browser als einfacher Text angezeigt. Dort siehst du alle Regeln für Suchmaschinen-Crawler, wie User-agent, robots.txt disallow all oder Allow. Auch die dynamisch generierte WordPress robots.txt wird dir über diesen Weg angezeigt.

Wenn du deine robots.txt bearbeiten oder erstellen willst, geschieht das normalerweise über den Webserver, dein Content-Management-System im Stammverzeichnis der Website oder über ein WordPress Plugin. Die Bearbeitung mit Hilfe eines WordPress Plugins ist der einfachste Weg und auch für alle ohne technischen Hintergrund geeignet. Nach der Anpassung ist die bearbeitete Datei sofort über die URL abrufbar, und Suchmaschinen können die neuen Anweisungen beim nächsten Crawling erkennen.

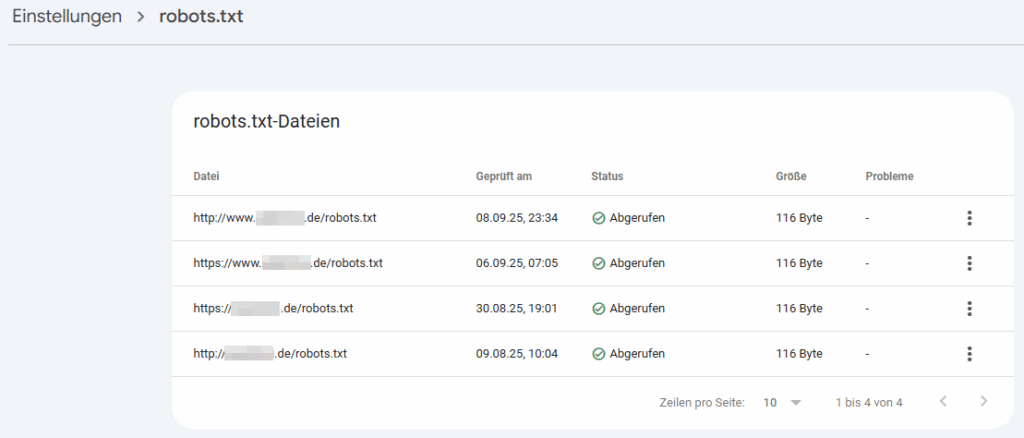

Wissenswert: robots.txt Tester

Ein robots.txt Tester ist ein Tool, mit dem du prüfen kannst, ob deine Datei korrekt eingerichtet ist und ob die Regeln tatsächlich so funktionieren, wie du es dir vorstellst. Damit lässt sich zum Beispiel kontrollieren, ob bestimmte Seiten oder Verzeichnisse für Crawler gesperrt oder erlaubt sind.

Du kannst deine robots.txt zum Beispiel mit folgenden Tools testen:

- Google Search Console

- Bing Webmaster Tools

- Rank Math robots.txt Tool

- SE Ranking robots.txt Tool

Es gibt zahlreiche kostenlose Tools zum Testen der robots.txt. Die aufgelisteten sind die auf Basis meiner Erfahrung die einfachsten Möglichkeiten.

Wie bearbeite ich die robots.txt?

Wenn du bisher noch keine eigene robots.txt für deine WordPress Website angelegt hast und die dynamisch generierte robots.txt verwendest, kannst du diese Datei noch nicht aufrufen und bearbeiten.

Ich empfehle dir in diesem Fall einen der beiden Wege:

- Manuelles Anlegen: Erstelle manuell eine robots.txt mit einem kostenlosen Tool wie Notepad++ oder Sublime. Lade diese Datei im Nachgang in das Stammverzeichnis deiner Website hoch.

- SEO-Plugins: Mit kostenlosen SEO-Plugins wie Rank Math oder Yoast kannst du deine robots.txt bequem aus deinem Backend bearbeiten.

robots.txt manuell anlegen und bearbeiten

1. robots.txt Datei erstellen

- Öffne ein Programm wie Sublime oder Notepad ++

- Füge dort den Inhalt deiner gewünschten robots.txt ein

- Speichere die Datei als TXT-Datei mit Namen robots.txt

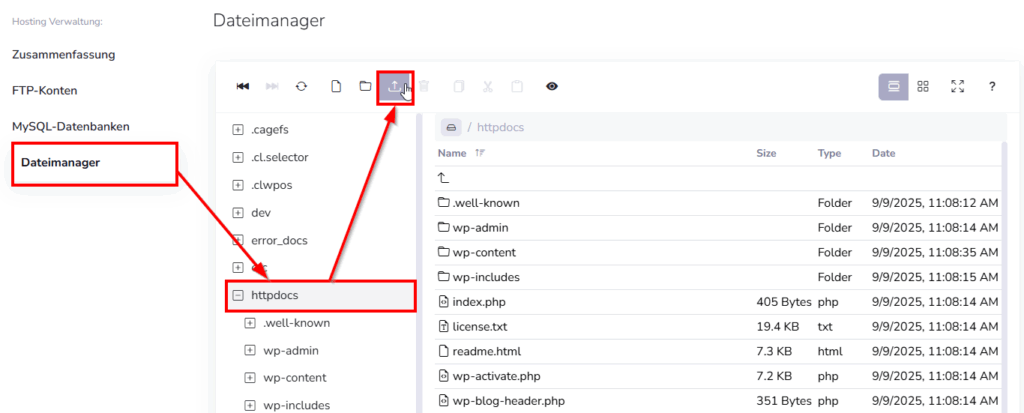

2. Auf Stammverzeichnis über Hosting zugreifen

Hinweis: Diese Anleitung ist auf die Oberfläche von WPspace angepasst und variiert von Hoster zu Hoster.

- Logge dich in deinem Kundendashboard ein

- Klicke auf Tarif verwalten um in deine WordPress Verwaltung zu gelangen

- Wähle im oberen Reiter “Mein Hosting”

- Wähle unter der Hosting Verwaltung “Dateimanager” und navigiere in dein Stammverzeichnis, in der Regel “httpdocs”

- Klicke auf Upload und lade die erstellte robots.txt hoch

Alternativ kannst du auch mit einem FTP-User und FTP-Tool wie Filezilla auf das Hauptverzeichnis deiner Website zugreifen und deine erstellte Datei hochladen.

Tipp 💡: Wenn du ein WordPress Hosting von WPspace nutzt, kannst du jeder Zeit das Support-Team kontaktieren, um Unterstützung bei der Bearbeitung deiner robots.txt zu erhalten. Eine Anleitung dazu findest du ebenso bei uns im Help Center.

robots.txt mit Plugins bearbeiten

Der einfachste Weg deine robots.txt zu bearbeiten, ist mit Hilfe eines SEO-Plugins. Die Bearbeitung der robots.txt ist hier bereits eine kostenlose Funktion von verschiedenen Plugins. So kannst du die robots.txt direkt in deinem WordPress Dashboard schnell und einfach bearbeiten, ohne dass du die Datei manuell öffnen und bearbeiten musst.

Folgende WordPress Plugins empfehle ich dir:

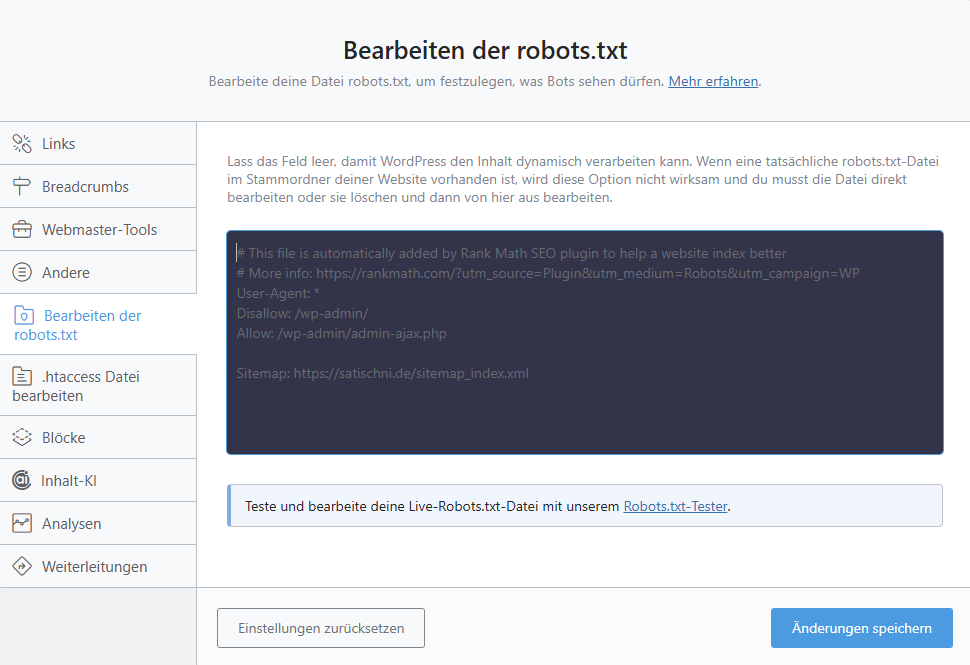

1. Rank Math:

Rank Math gehört zu den beliebtesten SEO Plugins und ist ebenso unsere Empfehlung für SEO-WordPress-Plugins. Um deine robots.txt mit Rank Math zu bearbeiten, logge dich zuerst in deinem WordPress Dashboard ein. Wähle danach “Rank Math SEO” > “Allgemeine Einstellungen” > “Bearbeiten der robots.txt”. Hier kannst du nun deinen neuen Code einfügen.

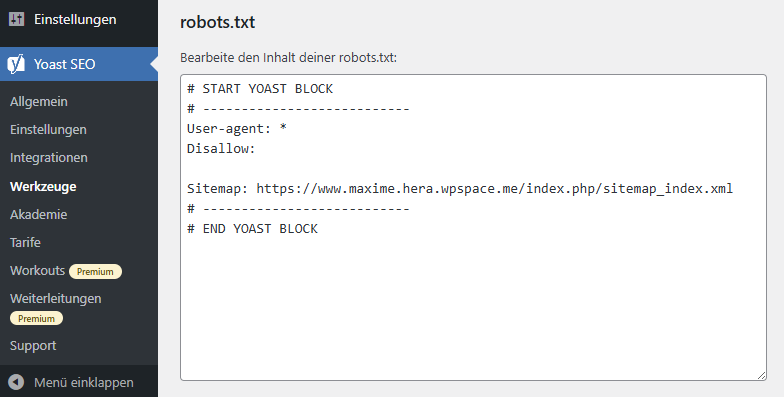

2. YOAST SEO:

Mit 10+ Millionen aktiven Installationen (Stand 08.09.2025) ist YOAST SEO das weltweit meist genutzte SEO Plugin. Auch hier hast du die Möglichkeit nativ deine robots.txt zu bearbeiten. Navigiere dazu unter “YOAST SEO” > “Werkzeuge” > “Datei-Editor”. Danach kannst dir mit einem Klick eine robots.txt Datei erstellen und im Anschluss bearbeiten.

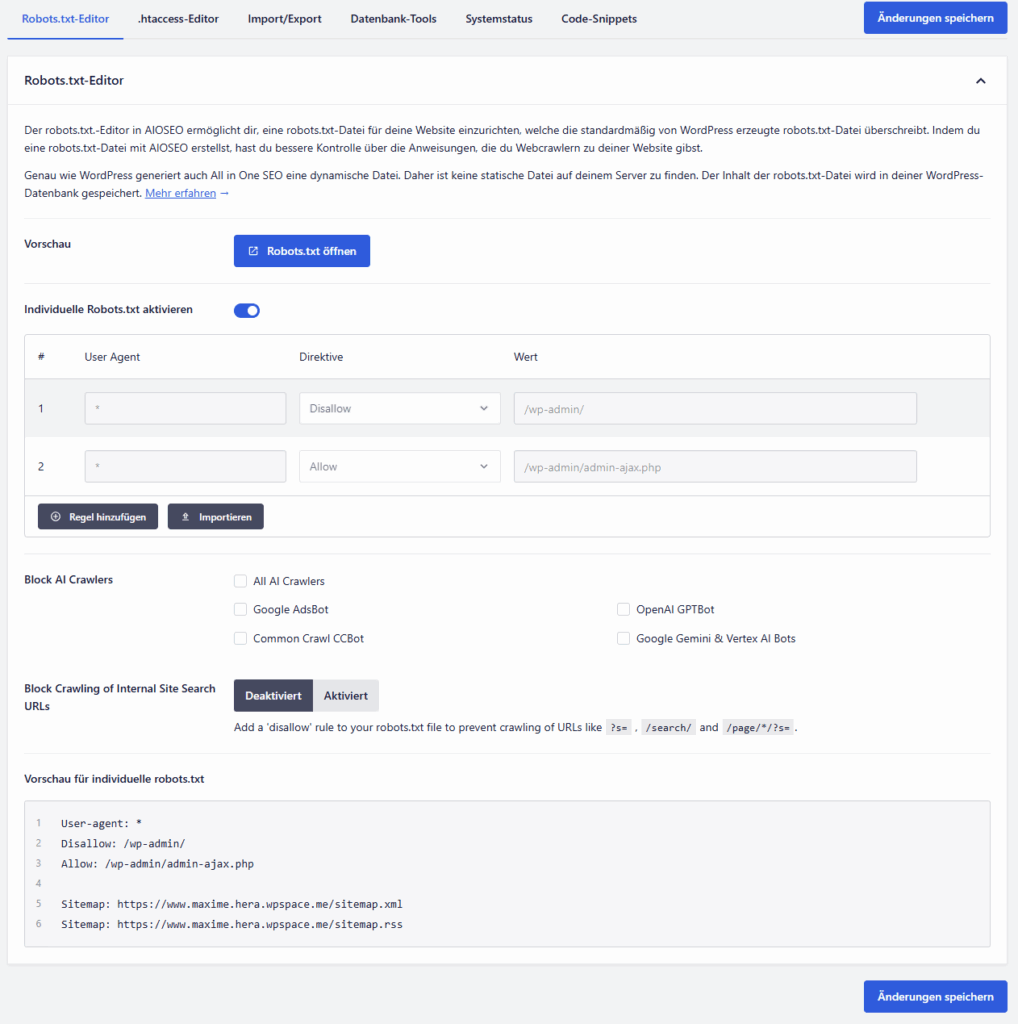

3. All in One SEO:

Das SEO-Plugin “All in One SEO” bietet die wohl übersichtlichste Oberfläche zur Bearbeitung deiner robots.txt. Um die Datei zu bearbeiten, navigiere in deinem WordPress Dashboard unter “All in One SEO” > “Werkzeuge” > “robots.txt Editor”. Im Anschluss kannst du die individuelle robots.txt aktivieren und deine gewünschten Regeln ergänzen.

Solltest du bereits eines der Plugins nutzen, empfehle ich dir kein zusätzliches Plugin zu installieren. Denn jedes zusätzliche Plugin macht WordPress langsam und schafft zusätzliche Sicherheitsrisiken.

Insgesamt ist die Bearbeitung deiner robots.txt mit Hilfe eines Plugins viel einfacher, schneller und fehlerfreier im Gegensatz zum manuellen Bearbeiten.

Warum ist die robots.txt wichtig für SEO?

Die robots.txt ist ein kleines, aber sehr wichtiges Werkzeug für SEO, weil sie Suchmaschinen-Crawlern dabei hilft, eine Website effizient zu durchsuchen und die relevanten Seiten zu indexieren.

Mit ihrer Hilfe lassen sich beispielsweise Admin-Bereiche, Login-Seiten oder interne Filterseiten blockieren, die für Nutzer und Suchmaschinen irrelevant sind. Dadurch wird verhindert, dass unnötige oder doppelte Inhalte das Ranking verwässern oder Duplicate-Content-Probleme entstehen.

Darüber hinaus unterstützt die robots.txt die Optimierung des sogenannten Crawl-Budgets, also der begrenzten Anzahl von Seiten, die Suchmaschinen in einem bestimmten Zeitraum durchsuchen können. Indem unwichtige Seiten ausgeschlossen werden, können Crawler sich auf die wirklich relevanten Inhalte konzentrieren und diese schneller indexieren.

Auch sensible Bereiche wie interne Testseiten werden durch die robots.txt vor der Indexierung geschützt, was sowohl die SEO-Leistung als auch die Sicherheit der Website verbessert. Ohne eine korrekt konfigurierte robots.txt kann es leicht passieren, dass wichtige Inhalte nicht gecrawlt werden oder unerwünschte Inhalte in den Suchergebnissen auftauchen. Richtig eingesetzt unterstützt die robots.txt also die Sichtbarkeit und Effizienz einer Website in den Suchmaschinen erheblich.

robots.txt ist nur ein Teil von SEO

Die robots.txt ist nur ein kleiner Teil der gesamten Suchmaschinenoptimierung. Wer langfristig Sichtbarkeit aufbauen will, braucht eine ganzheitliche SEO-Strategie, die sowohl technische Grundlagen als auch Content und Backlinks berücksichtigt.

Gerade Unternehmen, die ihre SEO-Aufgaben nicht intern abbilden können oder möchten, greifen dabei oft auf White Label SEO zurück. So lassen sich professionelle Optimierungen unkompliziert outsourcen, während die robots.txt eine wichtige Basis für die technische Steuerung des Crawlings bildet.

Was passiert, wenn ich keine robots.txt habe?

Wenn du eine WordPress Website hast, hast du automatisch eine Standard robots.txt. Diese Standard-Datei reguliert allerdings lediglich den Zugriff auf deinen Admin-Bereich.

Wenn du keine robots.txt hast bzw. keine manuellen Anpassungen vorgenommen hast, können Suchmaschinen-Crawler grundsätzlich alle Seiten deiner Website durchsuchen. Das bedeutet, dass es keine gezielten Anweisungen gibt, welche Bereiche sie ignorieren sollen, und alle Inhalte potenziell indexiert werden.

In den meisten Fällen ist das nicht direkt ein Problem, besonders bei kleinen oder einfachen Websites. Allerdings kann es bei größeren Websites oder solchen mit vielen sensiblen, unwichtigen oder doppelten Inhalten zu Problemen kommen:

Crawler verschwenden ihr Crawl-Budget auf unwichtige Seiten, und unerwünschte Inhalte könnten in den Suchergebnissen auftauchen. Außerdem können Duplicate-Content-Probleme entstehen, wenn ähnliche Inhalte unter mehreren URLs verfügbar sind.

Zusätzlich können Crawler auf einer Website viel Traffic und damit Auslastung erzeugen, was die Performance deiner Website deutlich beeinflussen kann. Vor allem der TikTok-Crawler ist dafür bekannt die Websites sehr aggressiv zu crawlen. Dadurch kann es je nach Umfang und Basis der Website sogar zu einem Ausfall kommen.

Kurz gesagt: Ohne robots.txt gibt es keine gezielte Steuerung der Indexierung. Die Suchmaschinen durchsuchen die Website frei, was die Performance deiner Website negativ beeinflussen, die Effizienz des Crawlings mindern und die SEO-Leistung beeinträchtigen kann.

Alternativen zur robots.txt

Die robots.txt ist praktisch, aber nicht immer die beste Wahl, um Inhalte von Suchmaschinen fernzuhalten. Je nach Anwendungsfall gibt es bessere Alternativen:

- noindex-Meta-Tag: Verhindert die Indexierung einzelner Seiten direkt im HTML-Code.

- nofollow-Meta-Tag: Sorgt dafür, dass Suchmaschinen Links auf einer Seite nicht folgen.

- HTTP-Header: Eine serverseitige Lösung, mit der du Indexierungsregeln für ganze Dateitypen festlegen kannst.

- Passwortschutz oder .htaccess: Schützt sensible Bereiche (z. B. Staging-Umgebungen) zuverlässig vor unerwünschtem Zugriff.

robots.txt – ein wertvolles Werkzeug

Die robots.txt mag unscheinbar wirken, ist aber ein zentrales Werkzeug für ein sauberes und effizientes Crawling deiner WordPress Website, was ein Bestandteil der Suchmaschinenoptimierung ist. Sie gibt dir die Möglichkeit, den Zugriff von Crawlern gezielt zu steuern, unwichtige oder doppelte Inhalte vom Crawling auszuschließen und so das Crawl-Budget optimal zu nutzen.

Durch die Einschränkungen der Crawler minimierst du das Risiko von Performanceeinbußen oder gar Ausfällen, die durch ein zu aggressives Crawling passieren können. Dazu solltest du immer deine Logs und Besucherstatistiken auf Auffälligkeiten beobachten.

Gleichzeitig schützt die robots.txt sensible Bereiche deiner Website davor, in den Suchergebnissen aufzutauchen. Zwar ersetzt sie keine Sicherheitsmaßnahmen, doch richtig eingesetzt trägt sie wesentlich dazu bei, dass Suchmaschinen die wirklich relevanten Inhalte deiner Website schnell erfassen und indexieren. Wer seine robots.txt bewusst einsetzt, schafft damit die Grundlage für eine bessere Sichtbarkeit, schnellere Performance und ein nachhaltiges SEO-Fundament.